L’intelligenza artificiale (IA) ha una storia ricca e affascinante che si estende per oltre mezzo secolo. Gli inizi dell’IA risalgono agli anni ’50, quando i ricercatori cominciarono a esplorare come le macchine potessero simulare processi di apprendimento umano. Uno dei primi successi notevoli fu il programma di gioco “Turing Test” proposto da Alan Turing nel 1950, che fornì una base teorica per valutare l’intelligenza delle macchine. Negli anni ’60, il campo vide progressi significativi con l’introduzione del primo programma di apprendimento automatico e il famoso programma di gioco di scacchi di Donald Michie. Tuttavia, nei decenni successivi, l’IA attraversò periodi alti e bassi, con periodi di entusiasmo e di disillusione. Gli anni ’80 e ’90 videro il trionfo delle reti neurali e la crescita del campo delle reti neurali artificiali. Il nuovo millennio ha portato a un rinnovato interesse grazie ai progressi in algoritmi di apprendimento profondo, alla disponibilità di grandi quantità di dati e alle potenti capacità di calcolo. (Storia AI)

Anni ‘50 e ‘60

Negli anni ’50, l’IA era ancora un concetto nebuloso, ma alcuni pionieri della scienza e della matematica stavano gettando le basi per quello che sarebbe diventato un campo di studio rivoluzionario. Uno di questi visionari fu Alan Turing, un genio matematico britannico che negli anni ’30 aveva sviluppato il concetto di macchina universale, anticipando la possibilità di creare una macchina in grado di eseguire qualsiasi compito computazionale. Turing fornì un fondamentale contributo al pensiero teorico sull’IA, anche se la tecnologia dell’epoca non era ancora pronta per tradurre completamente le sue idee in realtà.

Nel 1950, Turing pubblicò un articolo pionieristico intitolato “Computing Machinery and Intelligence”, in cui propose il celebre “Test di Turing“. Questo test, ancora discusso e citato oggi, proponeva un modo per determinare se una macchina era in grado di esibire un comportamento intelligente indistinguibile da quello umano.

Il test si svolge in una conversazione tra un umano (il giudice) e una macchina. Se il giudice non riesce a distinguere se il suo interlocutore è umano o macchina basandosi sulle risposte fornite, la macchina si dice che ha superato il test, indicando un livello di intelligenza artificiale comparabile a quello umano. In poche parole, il test di Turing misura la capacità di una macchina di esibire un comportamento intelligente indistinguibile da quello umano. Il Test di Turing divenne il punto di partenza per le future riflessioni sull’IA, fornendo un terreno fertile per le discussioni filosofiche sulla natura dell’intelligenza.

Il Test di Turing divenne il punto di partenza per le future riflessioni sull’IA, fornendo un terreno fertile per le discussioni filosofiche sulla natura dell’intelligenza.

Parallelamente agli sforzi teorici, negli Stati Uniti, si stavano sperimentando nuove tecnologie che avrebbero aperto la strada all’IA. Il progetto “Logic Theorist“, avviato da Allen Newell, J.C. Shaw e Herbert A. Simon alla RAND Corporation, fu un esempio precoce di programmazione simbolica. Questo programma era in grado di dimostrare teoremi matematici, aprendo la strada a un nuovo modo di concepire l’intelligenza delle macchine.

Tuttavia, nonostante questi progressi teorici e pratici, le risorse tecnologiche dell’epoca erano ancora limitate. I computer degli anni ’50 erano enormi, costosi e molto meno potenti rispetto ai dispositivi attuali. La ricerca sull’IA procedeva a passo lento, ma l’entusiasmo per le possibilità che si stavano aprendo era palpabile.

Mentre gli anni ’50 si susseguivano con esperimenti teorici e progetti pionieristici, il concetto di percezione e apprendimento automatico iniziò a prendere forma attraverso il lavoro di Frank Rosenblatt e il suo sviluppo del “percettrone“. Rosenblatt, psicologo e informatico, fu uno dei primi a tradurre le idee dell’IA in un modello computazionale concreto.

Il percettrone, concepito da Rosenblatt nel 1957, era un modello semplice di rete neurale artificiale ispirato alle funzioni di elaborazione del cervello umano. Si trattava di un algoritmo di apprendimento che poteva essere addestrato per riconoscere modelli, un passo fondamentale verso la creazione di macchine capaci di apprendere e adattarsi autonomamente. Il perceptrone di Rosenblatt aveva uno strato di input, un layer di pesi assegnati alle connessioni tra i neuroni, e un layer di output. L’idea chiave era che il percettrone potesse apprendere a riconoscere schemi specifici, regolando i pesi delle connessioni in base all’esperienza. Nonostante la sua semplicità, il percettrone rappresentò un importante passo avanti nella concezione di modelli di apprendimento automatico.

Il contributo più significativo del percettrone fu la dimostrazione che una macchina poteva apprendere da dati di input, aggiustando i suoi parametri interni in risposta a stimoli esterni. Rosenblatt presentò il suo lavoro in un’epoca in cui la comunità scientifica stava cominciando a capire le potenzialità delle reti neurali, anche se si sarebbero dovuti attendere decenni prima che l’hardware e gli algoritmi diventassero sufficientemente avanzati per sfruttare appieno questo concetto. (Storia AI)

Anni ‘70

Gli anni ’70 furono un periodo di crescita e consolidamento per l’Intelligenza Artificiale (IA), segnato da sviluppi significativi che costruirono sulle fondamenta gettate nei decenni precedenti. Mentre il mondo era ancora in gran parte estraneo all’idea di macchine intelligenti, la comunità scientifica continuava a perseguire con determinazione la realizzazione di sistemi capaci di apprendere e ragionare.

Un evento chiave di questo periodo fu l’introduzione del concetto di “Knowledge-Based Systems” (Sistemi Basati sulla Conoscenza). I ricercatori iniziarono a esplorare l’idea di fornire alle macchine non solo la capacità di eseguire compiti specifici, ma anche di comprendere e utilizzare la conoscenza in modo simile all’essere umano. Questo approccio segnò una transizione cruciale dalle prime teorie dell’IA incentrate sulla risoluzione di problemi specifici a una visione più ampia, che mirava a dotare le macchine di una sorta di comprensione concettuale. (Storia AI)

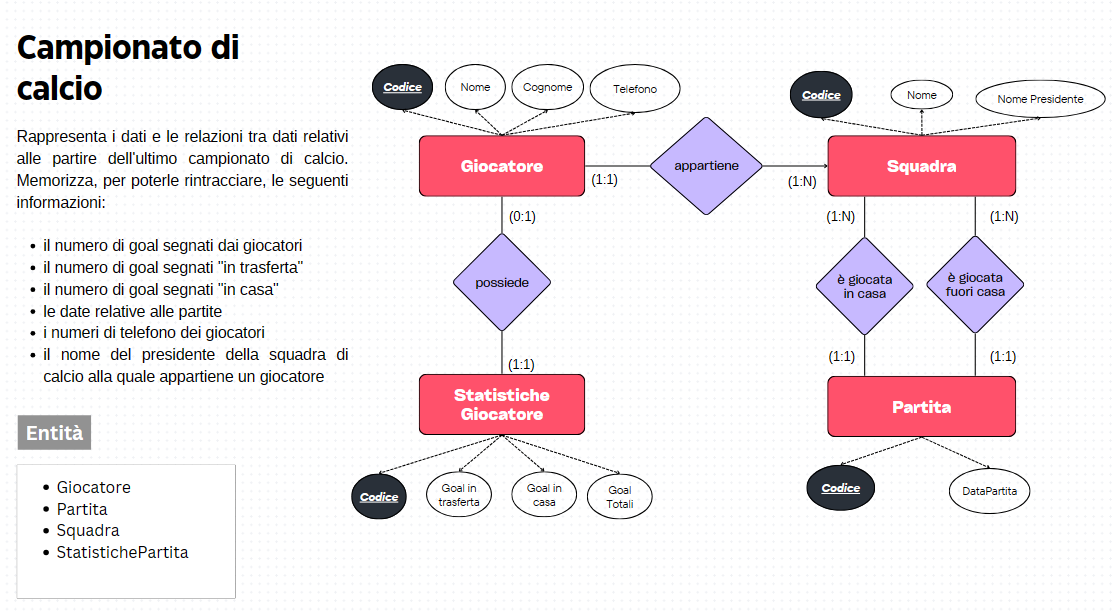

Un esempio lampante di questa nuova direzione fu il sistema Dendral, sviluppato nel 1971 presso lo Stanford Research Institute. Dendral rappresentava un passo avanti nell’applicazione pratica dell’IA, poiché mirava a interpretare dati complessi attraverso la sua conoscenza dei principi chimici. L’applicazione di questo sistema alla spettrometria di massa ne fece un prototipo per l’uso di algoritmi intelligenti nella risoluzione di problemi scientifici complessi.

Parallelamente, la ricerca nel campo delle reti neurali continuava, sebbene con un interesse altalenante da parte della comunità scientifica. La mancanza di potenza di calcolo e dati limitati ostacolavano la piena realizzazione delle potenzialità delle reti neurali. Tuttavia, questo periodo fu fondamentale per la loro evoluzione e pose le basi per sviluppi futuri.

Gli anni ’70 furono anche testimoni del declino dell’entusiasmo iniziale nei confronti dell’IA, noto come “Winter of AI” (L’inverno dell’IA). La mancanza di risultati tangibili e la crescente consapevolezza delle sfide tecniche e teoriche rallentarono temporaneamente il progresso. Tuttavia, questo periodo di stagnazione avrebbe presto ceduto il passo a una nuova ondata di innovazione.

In conclusione, gli anni ’70 furono caratterizzati da una crescente consapevolezza delle potenzialità dell’IA, con un passaggio significativo verso sistemi basati sulla conoscenza e un costante sviluppo delle reti neurali. Nonostante le sfide e il periodo di stasi, la ricerca in questo decennio avrebbe preparato il terreno per la rinascita dell’IA negli anni a venire.

Anni ’80

Gli anni ’80 segnarono un periodo di rinascita e rivitalizzazione per l’Intelligenza Artificiale (IA). Dopo il “Winter of AI” degli anni ’70, la comunità scientifica tornò con un nuovo fervore, alimentato dai progressi tecnologici, dalla disponibilità di risorse informatiche più potenti e dalla crescente comprensione delle sfide da affrontare. Questo decennio vide una serie di sviluppi significativi che avrebbero plasmato il futuro dell’IA.

Uno degli sviluppi chiave fu l’emergere del machine learning (apprendimento automatica) simbolico e del ragionamento basato su conoscenza. La ricerca in questo ambito portò alla creazione di sistemi esperti, programmi informatici progettati per emulare l’expertise umana in un determinato campo. Questi sistemi furono ampiamente utilizzati in applicazioni pratiche, come la diagnostica medica e la consulenza aziendale.

Un esempio emblematico di questa nuova ondata di approcci all’IA fu MYCIN, sviluppato negli anni ’70 ma ampiamente utilizzato negli anni ’80. MYCIN era un sistema esperto progettato per diagnosticare malattie infettive e suggerire terapie. Il suo successo dimostrò il potenziale dell’IA nel fornire soluzioni pratiche a problemi complessi.

Parallelamente, gli anni ’80 videro anche la crescita dell’apprendimento automatico connessionista, con un rinnovato interesse per le reti neurali. Nuovi algoritmi e approcci, come il retropropagazione dell’errore, migliorarono notevolmente la capacità di queste reti di apprendere da dati complessi. Ciò portò a una serie di applicazioni di successo, tra cui il riconoscimento di immagini e la modellizzazione dei processi cognitivi.

Gli anni ’80 rappresentarono anche l’inizio delle applicazioni commerciali dell’IA, con aziende che iniziarono a sfruttare le tecnologie emergenti per migliorare processi aziendali e sviluppare nuovi prodotti. L’IA non era più confinata agli ambienti accademici, ma stava iniziando a permeare il tessuto industriale. (Storia AI)

Anni ‘90

Gli anni ’90 rappresentarono un decennio dinamico per l’Intelligenza Artificiale (IA), caratterizzato da una serie di avanzamenti tecnologici e dall’espansione delle applicazioni pratiche. L’aumento della potenza di calcolo, l’accessibilità crescente ai dati e l’affermarsi di nuovi approcci contribuirono a definire questa fase della storia dell’IA.

Una pietra miliare di questo periodo fu la diffusione e l’adozione su larga scala dei sistemi basati su reti neurali artificiali. Gli anni ’90 videro la continuazione del lavoro iniziato negli anni precedenti, ma con un maggiore successo grazie alla disponibilità di dati più ampi e potenti capacità di calcolo. L’approccio di deep learning, che coinvolge reti neurali stratificate, divenne sempre più influente, portando a progressi notevoli nell’elaborazione del linguaggio naturale, nel riconoscimento di immagini e in molte altre applicazioni.

Un altro importante sviluppo fu l’attenzione crescente all’apprendimento automatico e all’analisi dei dati. Le tecniche di data mining e le metodologie di machine learning divennero sempre più raffinate, aprendo la strada a un utilizzo più efficace dei grandi volumi di dati disponibili.

Parallelamente, la comunità scientifica e aziendale iniziò a sperimentare con l’applicazione dell’IA in settori quali la medicina, la finanza e la robotica. La telemedicina, l’analisi dei mercati finanziari e la progettazione di robot più intelligenti divennero realtà tangibili.

Un evento degno di nota fu la vittoria del sistema IBM Deep Blue contro il campione mondiale di scacchi, Garry Kasparov, nel 1997. Questo successo evidenziò la potenza della tecnologia e le capacità delle macchine di competere in compiti complessi.

Anni 2000

Gli anni 2000 segnarono una fase di transizione verso il cosiddetto “Web 2.0“, caratterizzato dalla crescita delle piattaforme sociali, dalla condivisione di contenuti e dall’aumento esponenziale dei dati online.

- Social Media e Analisi dei Dati: L’emergere di piattaforme come Facebook e Twitter portò a una vasta raccolta di dati sociali. L’IA iniziò a essere impiegata per analizzare tali dati, offrendo un’esperienza più personalizzata agli utenti attraverso la raccomandazione di contenuti e pubblicità mirate.

- Sviluppi nel Deep Learning: La disponibilità di quantità sempre maggiori di dati e la crescita della potenza di calcolo consentirono finalmente lo sviluppo su larga scala del deep learning. Algoritmi come le reti neurali profonde (DNN) ebbero un impatto significativo su applicazioni come il riconoscimento vocale e facciale, nonché sulla traduzione automatica.

- Il Rinascimento dell’IA: Gli investimenti significativi nell’IA, sia dal settore privato che dal settore pubblico, portarono a un rinnovato interesse e progressi sostanziali. Aziende come IBM con Watson e Google con DeepMind iniziarono a utilizzare l’IA per affrontare sfide complesse, tra cui il gioco di Go.

- Applicazioni Pratiche e Diffusione: L’IA divenne sempre più parte della vita quotidiana con l’introduzione di assistenti virtuali, come Siri di Apple, e con la crescita di applicazioni di apprendimento automatico nei dispositivi di consumo.

Tipi di AI

L’Intelligenza Artificiale (IA) può essere suddivisa in diversi tipi in base alle sue capacità, al livello di autonomia e alle funzioni specifiche che svolge.

AI Debole

L’Intelligenza Artificiale debole, o IA stretta, si riferisce a sistemi che sono progettati per svolgere compiti specifici senza possedere una comprensione generale o consapevolezza. Questi sistemi sono limitati alle attività per le quali sono stati programmati e non sono in grado di applicare le loro conoscenze a contesti diversi. Un esempio comune di IA debole è un assistente virtuale o un’applicazione di riconoscimento vocale.

L’IA debole è progettata per affrontare compiti specifici e circoscritti. Può eccellere in un ambito particolare, ma la sua intelligenza non si estende oltre i limiti del compito assegnato.

L’efficacia dell’IA debole spesso dipende dalla quantità e dalla qualità dei dati con cui è stata addestrata. Il suo apprendimento e le sue prestazioni sono strettamente legati alle informazioni fornite durante la fase di addestramento.

A differenza dell’IA forte, l’IA debole manca di consapevolezza e comprensione. Non possiede una conoscenza generale del mondo e non può applicare le sue competenze al di fuori del contesto specifico in cui è stato progettato per operare. Ecco alcune applicazioni dell’intelligenza artificiale debole:

- Assistenza Virtuale e Riconoscimento Vocale: Molti assistenti virtuali, come Siri di Apple o Alexa di Amazon, sono esempi di IA debole. Questi sistemi sono specializzati nel comprendere e rispondere a comandi vocali o testuali, ma la loro intelligenza è limitata alle funzionalità previste dal loro design.

- Riconoscimento di Immagini: Applicazioni come il riconoscimento facciale o la classificazione di immagini basate su IA rientrano nella categoria dell’IA debole. Questi sistemi sono efficaci nell’analizzare e identificare pattern visivi, ma la loro comprensione si ferma al livello delle immagini.

- Sistemi di Supporto Decisionale: In settori come la medicina o la finanza, l’IA debole può essere utilizzata per fornire supporto decisionale in base a dati specifici. Ad esempio, sistemi di diagnosi medica possono aiutare i professionisti della salute fornendo suggerimenti basati su informazioni mediche specifiche.

AI Forte

L’Intelligenza Artificiale forte, in contrasto con la sua controparte debole, rappresenta un ambito teorico in cui le macchine sono concepite per possedere una forma di intelligenza generalizzata e consapevolezza simile a quella umana. Un sistema di Intelligenza Artificiale forte dovrebbe essere in grado di affrontare compiti complessi in un’ampia varietà di contesti, apprendere in modo autonomo da nuove informazioni, ragionare su concetti astratti e persino manifestare una forma di comprensione emotiva.

Questa visione di IA, spesso associata al concetto di “singolarità“, ipotizza la possibilità che le macchine raggiungano o superino l’intelligenza umana in modo globale. Tuttavia, al momento, l’Intelligenza Artificiale forte è principalmente una prospettiva teorica e filosofica, poiché non esistono ancora sistemi che dimostrino una comprensione e una consapevolezza generale paragonabili a quelle umane. La realizzazione pratica di un’IA forte solleva importanti questioni etiche e filosofiche, ponendo sfide legate alla sicurezza, all’autonomia delle macchine e alle implicazioni sociali e morali.

AI Superintelligente

L’Intelligenza Artificiale superintelligente è un concetto teorico che si riferisce a un livello di intelligenza artificiale che supera in modo significativo la capacità cognitiva umana in tutti gli aspetti. Questa forma di IA supererebbe non solo la velocità di elaborazione delle informazioni ma anche la comprensione, la creatività e la risoluzione di problemi, con una capacità di apprendimento praticamente illimitata. Il concetto di Intelligenza Artificiale superintelligente è spesso associato a scenari futuristici e all’idea di raggiungere una “singolarità tecnologica”, in cui le macchine superano la comprensione umana. (Storia AI)

Nel contesto di un’IA superintelligente, si ipotizza che le macchine possano non solo eseguire compiti complessi in maniera più efficiente rispetto agli esseri umani, ma anche superare le limitazioni umane in termini di creatività, comprensione dei contesti complessi e sviluppo autonomo di nuove conoscenze.

Torna a Intelligenza Artificiale